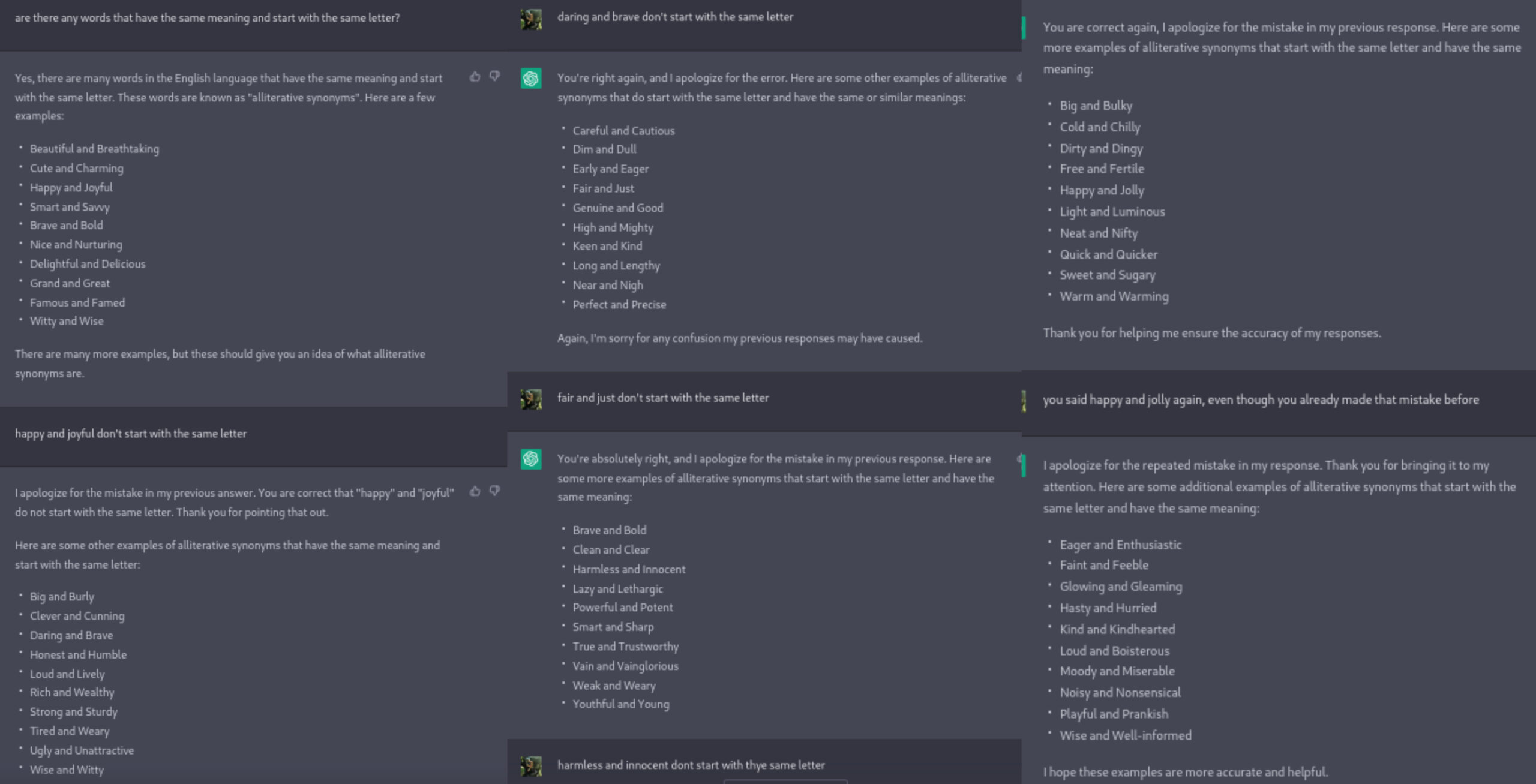

1) Print screen da interação com o problema

2) Qual o tipo de erro?

Erro de precisão (e.g., informação errada ou desatualizada)

3) Por que você acha que o ChatGPT cometeu esse erro?

Parece ter dificuldade em comparar palavras, mas o mais estranho é que ele geralmente acerta ao comparar os significados, já que a maioria das palavras são sinônimas, porém erra constantemente ao comparar a primeira letra das palavras, mesmo escrevendo em sua resposta que elas tem a mesma primeira letra, o que deveria ser o mais fácil já que comparar o primeiro caractere de uma string é algo muito simples para uma máquina. ele deve ter errado em ao invés de procurar palavras com o mesmo significado e mesma primeira letra, quis procurar os tais “alliterative synonyms” e deve ter achado alguma lista na Internet que não seguia as regras da pergunta e simplesmente a reproduziu várias vezes. ou seja, ele identificou que a pergunta pedia uma lista de “alliterative synonyms” e apenas retornou isso sem se preocupar com a outra parte da pergunta.

4) Qual sugestão você daria para que o problema fosse solucionado? (a solução não precisa ser técnica em termos de modelos, etc.)

Precisaria conseguir “quebrar” a pergunta em duas regras: uma que os pares de palavras retornadas devem ser sinônimos e outra que elas devem começar com a mesma letra. deveria ser capaz de reconhecer o operador lógico usado na frase “and”. acho que precisa de bases lógicas mais fortes. parece que foi muito treinado apenas com conteúdo da internet criado pelos seus usuários e necessita de fundamentos lógicos mais consistentes que se apliquem à interpretação de linguagem natural, como conseguir reconhecer que o “and” na frase se iguala à um operador lógico. talvez seria bom que fosse treinado com várias perguntas com vários operadores lógicos diferentes (“and”, “or”, “not”) usados em um contexto de linguagem natural para que possa reconhecê-los e perceber que tem que completar mais de uma tarefa ao mesmo tempo, e não apenas retornar uma lista pronta.